Special

2022.09.26 UP

【IBC 2022】レポート#2 放送におけるオブジェクトコンテンツ化とメタバースとの関係

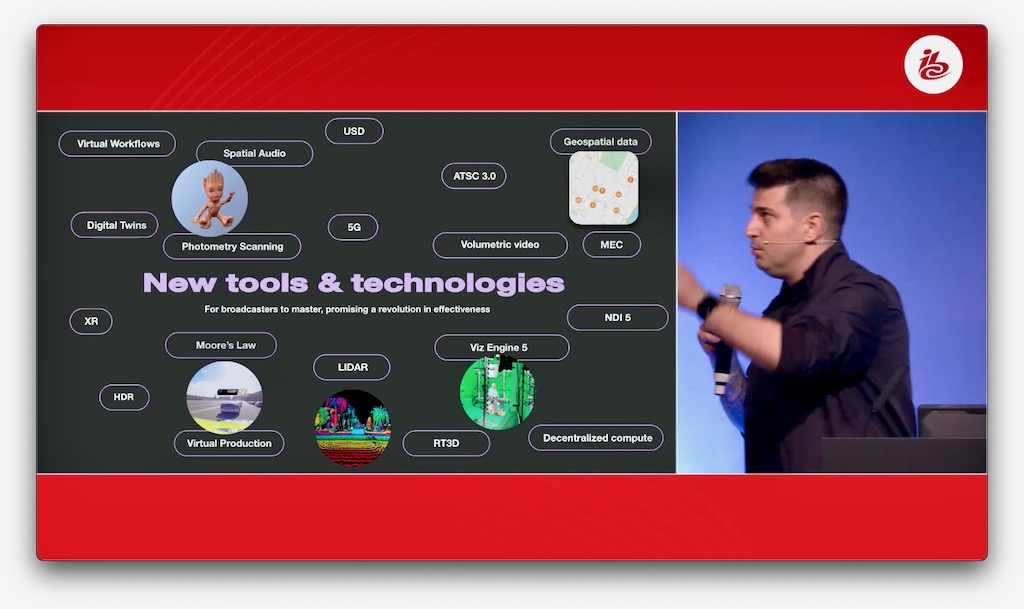

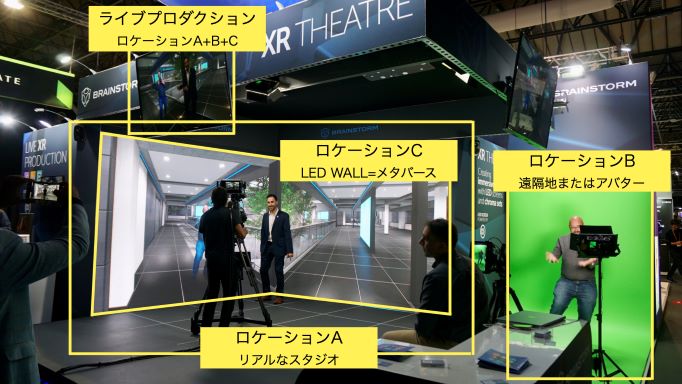

IBC2022では、DVBやEBUが放送でのOBM(Object-Based Media)化とメタバースに関する展示やセッションを多数開催した。欧州ではこうした新しい放送サービスを念頭に置いた上で、DVBでの標準化作業が行われている。

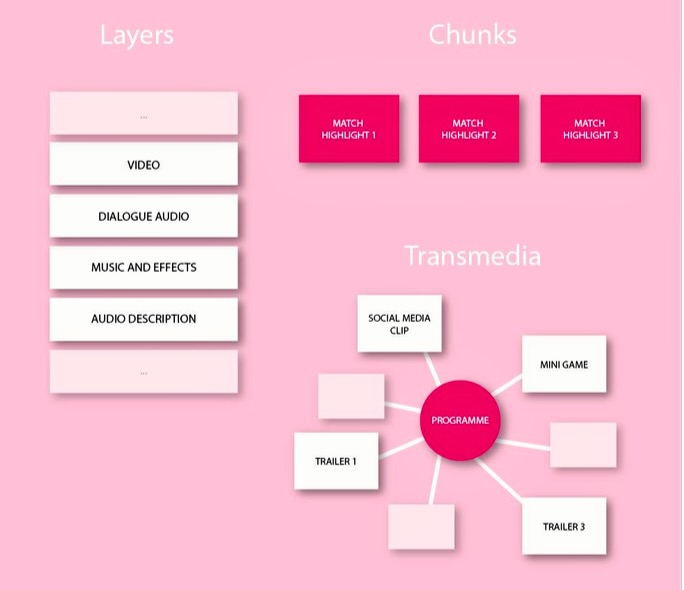

放送業界でコンテンツについて話すとき、いまだに「ライブラリ」や「アーカイブ」という言葉を用いることがある。ビデオやオーディオの番組は、たとえそれがメタデータを持つデジタルアセットであっても、固定化されて自己完結したブラックボックスとしてのみ考えられていることは機会と利便性を遺失している。