【SIGGRAPH ASIA 2011】論文セッションハイライト(2)MIT メディアラボが一兆分の一秒(ピコ・セカンド)で撮影する”ToF(Time-of-Flight)カメラ”を発表

2011.12.8 UP

(写真2)

(写真3)

(写真4)

(写真5)

12月12日から15日までの4日間にわたって香港で開催されるSIGGRAPH ASIA2011。論文セッションには、SIGGRAPH 2011で発表された手法の続編にあたるものから、SIGGRAPH 2011では見られなかった新たなCG技術のトレンドを感じさせるものまで、幅広い手法が登場する。夏のSIGGRAPHの論文セッションと比較すると、一般の人々によりなじみやすい実用性をアピールした手法が多いという、SIGGRAPH ASIAならではの論文セッションの魅力も健在であるように思われる。論文セッションの魅力といえば、手法を考案したプレゼンターとセッションに参加した人々とのリアルタイムな対話というものも欠かせない。実際にこれらの手法が、参加者にどのように受け止められ、その後どのように実用化に結びついてゆくのかが、今からとても楽しみだ。(倉地紀子)

■デジタルカメラの活用を拡大する独創的な手法が続々登場

今回の論文セッションの中でもひときわ独創性の高い手法が集まっているのが“Cameras and Appearance”と題したセッションだ。セッションに登場する4つの論文のうちの3つはいずれも「カメラで撮影した画像を活用して物体の見え方をつくりだしてゆく」というイメージベースドのアプローチを効率化するための手法、最後の一つはインタラクティブな髪の毛のレンダリングおよびエディティングの手法となっている。

イメージベースドのアプローチを効率化するというコンセプトの技法はこれまでにも数知れずSIGGRAPH論文として登場してきた。しかし、今回のものはまさに”今“という時代のCG技術の動向を象徴するものといえそうな点が興味深い。

イメージベースド・レンダリングはこれまで、さまざまな変換や補正の処理が必要であった。そのため、通常のカメラで撮影した画像をそのまま用いることはできなかった。理論的なベースこそ確立しているものの、現場での処理はケースバイケースでおこなわれてきたというのが実情だ。このイメージベースド・レンダリングの工程を、より汎用性の高いプロセスへと導いていくための手法がセッションの最初に登場する。発表するドイツのボン大学は、イメージベースド・レンダリングの考え方を導入した人間の表現(髪の毛、顔など)の研究でも定評がある。今回発表される手法は、このような研究の過程で問題視されてきた点を解消するための一つの手段ともいえそうだ。

続く2つの技法は、いずれも前述した”リフレクタンス関数“に相当するものを実際に物体の表面を撮影した画像から復元するためのものだ。MIT Media Labのカメラ・カルチャー・グループとコーネル大学から発表される。

これらの技法もすでに1990年代半ばから数多く登場してきている。今回の二つの論文の新たな工夫のポイントは、いずれも撮影をおこなうデバイスにcomputational photographyの考え方を取り入れた点にある。

リフレクタンス関数は光の入射方向と反射方向を引数とする関数となっている。そのため、撮影画像からこれを復元するためには、物体表面を照らすライトの方向と物体表面を撮影するカメラの方向のそれぞれの変化を緻密に計算するために、膨大な数の画像を撮影する必要があった。しかし、カメラ・デバイスにcomputational photographyの工夫を組み込むことによって、ライトとカメラの位置を固定して撮影した一方向からの撮影画像だけから、リフレクタンス関数を復元することを可能にしている。これは、撮影現場にとっても、非常に大きな進歩といえるだろう。computational photographyの考え方がCGレンダリングの王道といえる領域にまで取り入れられるようになったことの意義も大きいといえよう。

■一兆分の一秒(ピコ・セカンド)で撮影するMIT メディアラボのキャプチャー・カメラ

MIT Media Labのカメラ・カルチャー・グループが発表する手法では、一兆分の一秒(picosecond)という短い時間間隔で光をキャプチャーするTime-of-Flight(ToF)カメラと呼ばれるものが導入されている。従来のカメラではあれば交じり合って捉えられていた光の効果を、光が辿った経路の長さに応じて非常に細かく分離して捉えている。

分離された光の効果を比較することによって、従来のカメラでは捉えることのできなかった映像を生成できる。同グループでは一昨年、すでにコンピュータービジョンの分野での発表で、ToFカメラを用いて直接撮影していない部分の画像を生成する手法を発表して話題となった。今回の手法は、同様なコンセプトをCGレンダリングの中核を担う部分に応用した意欲的な手法だ。

具体的には、光の経路の長さに応じて光の効果を分離することによって、ライトとカメラの位置を固定した状態でも、光の入射方向と反射方向の違いに対応した反射率の違いを計測することが可能となるのだ。今年8月に開催したSIGGRAPH2011で、ウェタ社から発表されて話題となった新たなサブサーフェース・スキャタリング・モデルでは、ディフュージョンという現象を時間軸に沿って分解することによって、複雑な関数を単純なガウス関数に分解することを可能にしていたが、上記のToFカメラの導入でも同様の考え方が計測処理の効率化に大きく貢献している点は興味深い。

「時間軸に沿った解析」手法が、CGレンダリングの今後を担う一つのトレンドとなっていくのかもしれない。このプロジェクトにはKavita Bala氏も論文共著者として参画しており、「こういった新しいコンセプトのデバイスの導入は、大量のデータを驚くほど効率的に採取することを可能にし、それは将来的にグラフィックス技術がよりリアルなアニメーションやよりリアルな物体の見え方をその細部にまでわたってつくりだしていくための大きな鍵となるのだろう」と語っている。

■物体表面の凹凸を精密に表現

一方のコーネル大学が発表する手法では、エリアライト(step-edge lighting)を用いて、物体表面を黒と白で二分して見えるように撮影をする。物体表面が完全に滑らかであったとすると、撮影画像も半分は黒(影の部分)、半分は白(光の当たっている部分)に二分されるようにエリアライトを設定している。しかし、物体表面には必ず凹凸があるため、撮影画像の白と黒の境界部分にはちょうどフィルターをかけたような効果が表われる。そこで、この”フィルター”のかかり具合を分析することによって、物体表面でおこる反射の特徴を生成するというのがこの手法の基本的な考え方だ。

この手法ではリフレクタンス関数が表すような物体表面のミクロスケールの凹凸のみならず通常バンプマッピングなどで近似されているようなもう少し大きなスケール(meso-scale)の凹凸まで生成できることも大きな特徴となっている。

■北京・清華大学 テクスチャを用いて毛髪の質感を調整

髪の毛のレンダリング技法を発表するのは北京の清華大学だ。昨年夏のSIGGRAPHで同大学が発表した手法の改良版にあたるものだが、改良点になかなか奥深い意義がある。

毛のレンダリングには、2003年のSIGGRAPHで発表されたマシュナー・モデルという物理的に正確な毛のリフレクタンス関数を用いることが、最近の主流となっている。今回の手法は複雑なマシュナー・モデル関数を一次元のガウス関数に分解することを可能にしている。これによって前計算を行わずともGPU上でリアルタイムに物理的に正確な髪の毛のレンダリングをおこなうことができる。なおかつ、テクスチャを用いてインタラクティブに髪の毛の色や質感をエディットすることもできるというのが今回の手法のポイントだ。

同大学は、北京にあるマイクロソフト・リサーチ・アジアとの共著でテクスチャ関連のSIGGRAPH論文をたびたび発表している。前述したテクスチャ・エディティングの論文もその一つにあたる。

テクスチャを活用して髪の毛の色や質感をエディティングするという考え方は、これらの論文に基づいていると考えられる。一方で、マシュナー・モデル関数の一次元のガウス関数への分解は、本手法だけにとどまらない大きな潜在性を秘めていそうだ。

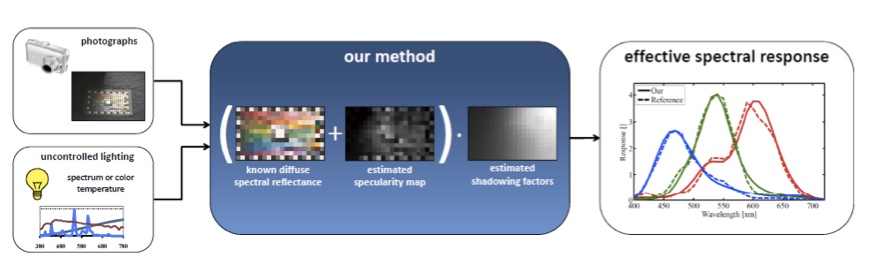

(写真1解説)セッション「 Cameras and Appearance」より

“Practical Spectral Characterization of Trichromatic Cameras”(Bonn University, GfaR mbH)

(c)20011 ACM, Inc.

イメージベースドのアプローチでは、撮影画像のピクセル値と実際のシーンの色や明るさとの間の物理的な関係をあらかじめ知っておく必要がある。より正確には各波長の光と画素との関係(effective spectral response)を知っておくことが望ましいのだが、この関係を知るためには特殊なライティングのもとで非常に煩雑な計測作業を繰り返さなくてはならならなかった。

今回発表される手法では、通常のライティングのもとでカラーチャートを撮影した画像にシンプルな解析を施すことによって上記の関係をうまく復元することを可能にしている。本来特殊なラボラトリーのような施設が必要とされる作業工程を、一般の現場に開放したということの意義は大きい。

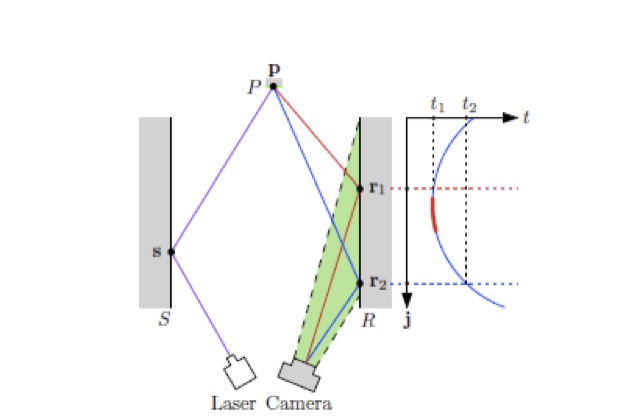

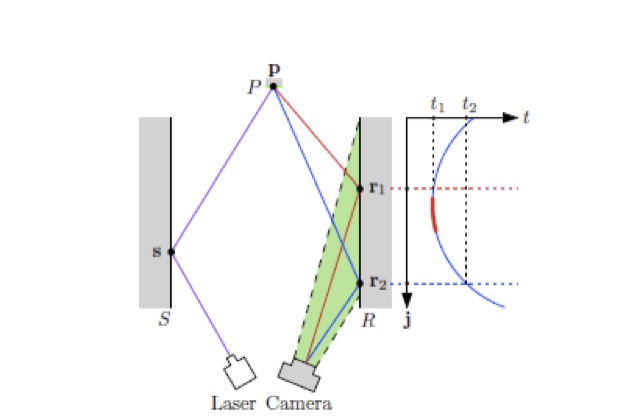

(写真2、3解説) セッション「 Cameras and Appearance」より

“Single View Reflectance Capture using Multiplexed Scattering

and Time-of-flight Imaging”(MIT Media Lab, Cornell University)

(c)20011 ACM, Inc.

この手法の旨みは、ToF(Time-of-Flight)カメラの導入によって、カメラの位置を固定したままでも、光の入射方向と反射方向をさまざまに変化させた場合の物体表面上の光の反射の特徴を一度に計測することを可能した点にある。

ToFカメラは光速に匹敵する速さで光をキャプチャーするので、図(a)(写真1)のように “辿った経路の長さの違う光”(s→p→r1とs→p→r2)を時間軸に沿って分離して(t1とt2)捉えることができる。ここではPにはリフレクタンス関数を復元する材質が貼り付けられており、“光が辿った経路の長さの違い”=“光の反射方向の違い”となっている。したがって、本来であればカメラ位置を移動させて計測しなければならないところを、カメラ位置を固定したままでも光の反射方向のバリエーションを与えて測定することができるのだ。同様にライト方向を固定したままでも光の入射方向のバリエーションを与えて測定することができる。

図(b)(写真2左)のように、異なった材質の複数のパッチ(ここでは9枚のパッチ)を壁に貼り付けて、複数(ここでは9種類)の材質のリフレクタンス関数を同時に復元することもできる。図(c)(写真2中央)は、9枚のうちの2枚のパッチをToFカメラでデーターを示しており、2つのカーブのそれぞれが2枚の異なった材質のパッチに対応している。図(d)(写真2右)は、2つのカーブのそれぞれを解析して2枚のパッチの材質(銅と石英)のリフレクタンス関数を復元し、これらのリフレクタンス関数を用いて球面をレンダリングした結果を示している。

本手法を発表するMIT Media Labのカメラ・カルチャー・グループを率いるRamesh Raskar氏は、つい最近「僕にとってcomputational photographyの時代は終った、次はcomputational light transportに取り組んでいきたい」と語っていたが、この手法はまさにその実践にあたるものともいえそうだ。

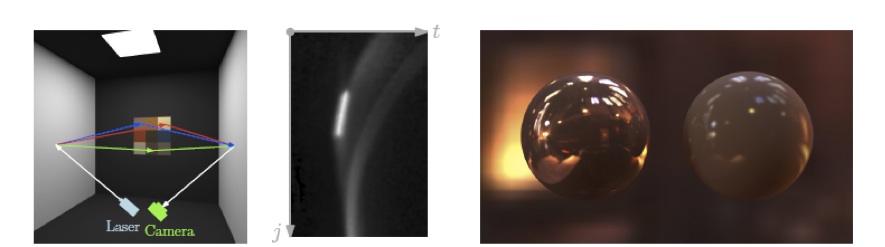

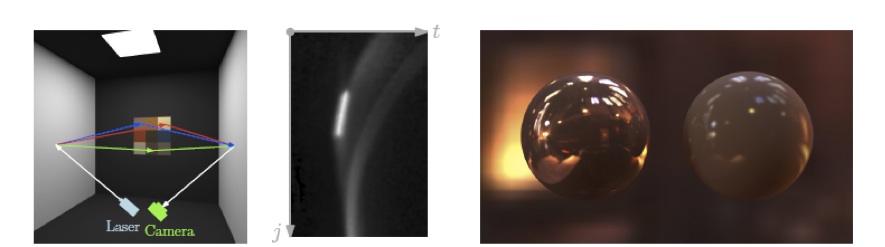

(写真4解説) セッション「 Cameras and Appearance」より

“Estimating Dual-scale Properties of Glossy Surfaces from Step-edge Lighting”(Cornell University)

(c)20011 ACM, Inc.

この手法では、一枚の撮影画像だけを用いて、物体表面の材質に依存する反射の特徴を、2つのスケールの“粗さ”(凹凸の分布)として復元する。一種目はリフレクタンス関数によって表されるミクロなスケールの凹凸、もう一種類目はバンプマッピングによって表されるようなもう少し大きなスケール(メソ・スケール)の凹凸だ。

計測では、LCDを用いて半分が黒・半分が白のエリアライトに相当するライティング(step-edge lighting)をつくりだし、このライティングのもとで反射の特徴を復元する物体表面を撮影する。もし物体表面に凹凸がまったくなければこの撮影画像は一本の境界線で黒・白に二分された画像となり、サーフェースにミクロ・スケールの凹凸のみが存在した場合には境界線の周りに黒から白へのグラデーションがかかった画像となる。

しかし、現実の世界の物体表面には、ミクロ・スケールの凹凸だけではなくメソ・スケールの凹凸も存在するので、図(a)のように一方向へのグラデーションだけではなくところどころでピクセルの黒から白への昇順が入れ替わったものとなる。そこで、まず図(a)の画像の各行を左から右に向かってピクセル色の黒から白への昇順が一方向になるように並べ換えて、図(b)のように仮想的にミクロ・スケールの凹凸のみが存在する物体表面を撮影した画像を生成し、この画像を解析してミクロ・スケールの凹凸を表わすリフレクタンス関数を復元する。次に図(a)から図(b)を差し引いて仮想的にメソ・スケールの凹凸だけが存在する物体表面を撮影した状態の画像(図 (c))を作成する。図 (c)をフーリエ空間上で解析して(図(d)(e))、図(f)のようにちょうどバンプ・マップの高さの分布にあたるもの(=メソ・スケールの凹凸の分布)を復元する。

手法を発表したコーネル大学のSteve Marshner氏の研究室は髪の毛の研究で名高いが、同氏はMarshner モデル(物理的に正確な髪の毛のリフレクタンス関数)の考案に先立ってリフレクタンス関数の計測・復元というテーマにおいても非常に画期的な研究成果を残してきており、10年という年月を経て発表された本手法は、ある意味でそれを“今”という時代さらに将来的な時代の要請にマッチするように進化させたものともいえそうだ。

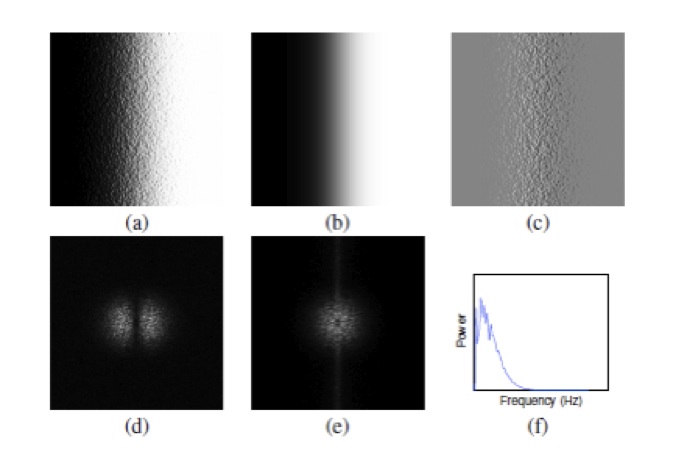

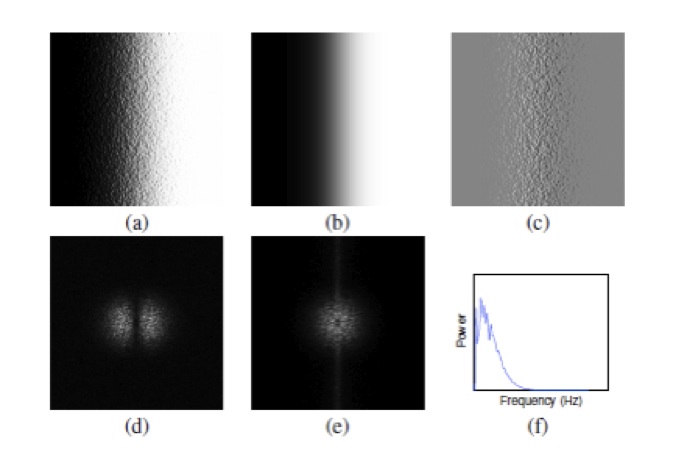

(写真5解説) セッション「 Cameras and Appearance」より

“Interactive Hair Rendering and Appearance Editing under Environment Lighting”(Tsinghua University)

(c)20011 ACM, Inc.

清華大学は昨年夏のSIGGRAPHで、環境光を基底に分解することによって、物理的に正確な毛のレンダリングを効率化する手法を発表した。今回の手法はそのアップデート版にあたるのだが、物理的に正確な毛のリフレクタンス関数にあたるMarshnerモデルを、1Dのガウス関数というGPU上のリアルタイム・レンダリングに適したシンプルな関数に分解したことの意義は大きい。

シミュレーション的要素の多いレンダリング技法であるにもかかわらず、テクスチャを用いたインタラクティブなコントロールに対して意欲的である点も大きな特徴といえる。画像のアニメーションは、ユーザーが髪の毛の各部分における光の吸収率の変化をペイントで指定して作成されており、“ヘア・カラー”のダイナミック・シミュレーションに相当するものともいえそうだ。

(写真2)

(写真3)

(写真4)

(写真5)